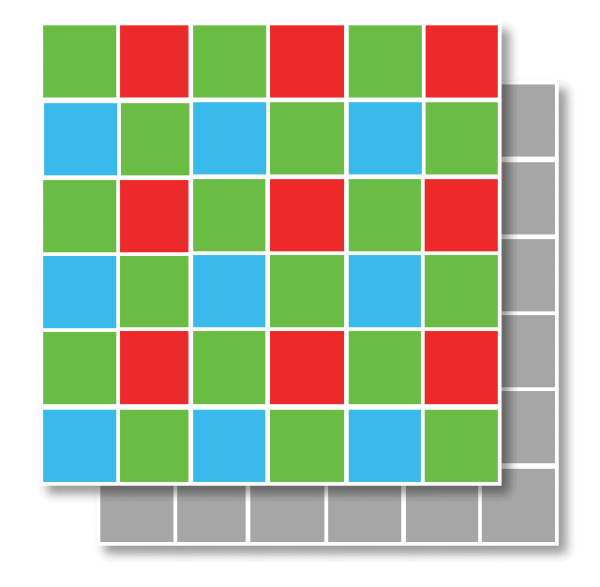

Una matrice Bayer è costituita da file alternate di filtri rosso-verde e verde-blu. Si noti come la matrice Bayer contenga il doppio di sensori verdi rispetto a quelli rossi o blu. Ogni colore primario non riceve una frazione uguale dell’area totale perché l’occhio umano è più sensibile alla luce verde rispetto a quella rossa e blu. La ridondanza con i pixel verdi produce un’immagine che appare meno rumorosa e con dettagli più fini di quanto si potrebbe ottenere se ogni colore fosse trattato allo stesso modo.

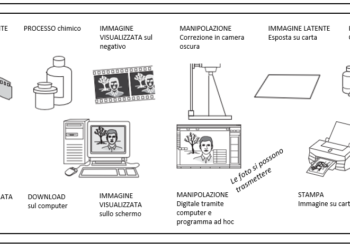

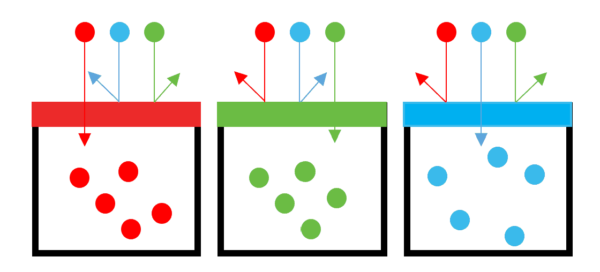

In un certo senso, i sensori delle fotocamere digitali sono daltonici. Possono registrare la luminosità, o la luminanza di un’immagine, ma non hanno alcuna nozione del colore della luce. Per fare questo, la maggior parte dei sensori (ad eccezione di un tipo speciale chiamato Foveon, usato in alcune fotocamere Sigma) sovrappone ai siti fotografici una serie di filtri di colore. Ogni pixel registra la luce rossa, verde o blu e ignora tutti gli altri. Quindi, ogni pixel in particolare potrebbe vedere la luce rossa (solo), mentre quello accanto potrebbe vedere la luce verde (solo), e il pixel sotto di esso nella riga successiva potrebbe essere sensibile alla luce blu (solo).

Come si potrebbe intuire, nel normale corso degli eventi, un pixel designato come verde-sensibile potrebbe non avere la fortuna di ricevere molta luce verde. Forse sarebbe stato meglio se quel pixel avesse registrato invece una luce rossa o blu. Fortunatamente, su una vasta gamma di pixel, un numero sufficiente di pixel con filtro verde riceverà luce verde, pixel con filtro rosso luce rossa, e pixel con filtro blu luce blu, che la media delle cose è di un discreto grado di precisione. Per compensare questa carenza, il valore reale del colore di un particolare pixel viene calcolato attraverso un processo chiamato interpolazione. Gli algoritmi integrati nel cir- cuito della fotocamera possono guardare i pixel circostanti per vedere quali sono i loro valori di colore e prevedere con una certa precisione ciò che ogni pixel dovrebbe essere in realtà. Per la maggior parte, queste supposizioni sono abbastanza accurate.

Per ragioni avvolte nella nebbia della scienza del colore, i pixel di un array di sensori non sono disposti in una rigida alternanza rosso-verde-blu, come ci si potrebbe aspettare che sia. Al contrario, i pixel sono disposti in quello che viene chiamato un modello Bayer (dal nome del Dr. Bryce Bayer della Kodak), mostrato nell’immagine di seguito dove è rappresentata solo una piccola porzione di un intero array di sensori. Una fila alterna pixel verdi e rossi, seguita da una fila che alterna filtri verde e blu. Il verde è “sovrarappresentato” per il modo in cui i nostri occhi percepiscono la luce: Siamo più sensibili all’illuminazione verde. Ecco perché i monitor monocromatici dei secoli bui dei computer erano più spesso display verde su nero.

Il processo di interpretazione dei valori dei pixel catturati e la loro trasformazione in una rappresentazione più accurata dei colori di una scena è chiamato demosaicizzazione. Con buoni algoritmi, il processo è accurato, ma un demosaicamento difettoso può produrre artefatti indesiderati nella foto (anche se, quasi per definizione, gli artefatti sono generalmente sempre indesiderati).

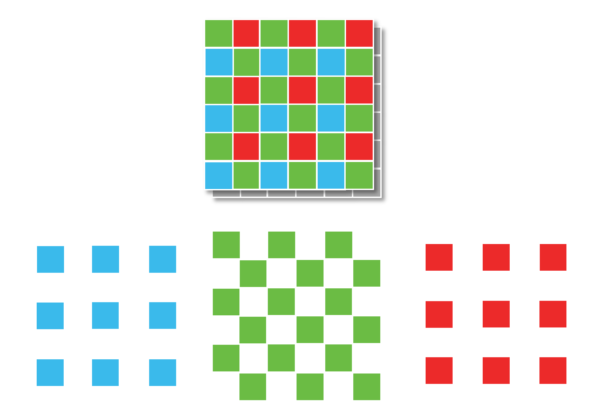

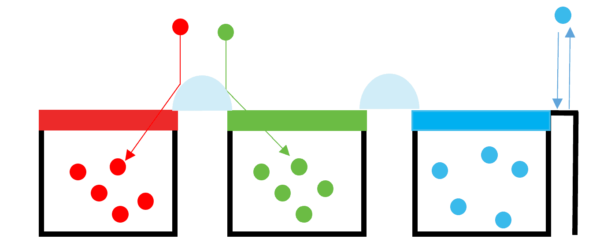

Naturalmente, l’uso di un modello Bayer significa che gran parte dell’illuminazione che raggiunge il sensore va sprecata. Solo circa la metà della luce verde viene effettivamente catturata, perché ogni riga è composta per metà da pixel verdi e per metà da pixel rossi o blu. Peggio ancora, viene registrato solo il 25% della luce rossa e blu. La Figura qui sotto fornisce una rappresentazione di ciò che accade sul sensore.

Nel nostro segmento di array di 36 pixel, ci sono solo 18 fotositi verdi filtrate e 9 di rosso e blu. Poiché non viene registrata tanta luce, la sensibilità del sensore si riduce (che richiede molta più luce per produrre un’immagine) e la risoluzione reale si riduce drasticamente. La vostra fotocamera digitale, con 10 megapixel di risoluzione, cattura in realtà tre immagini separate che misurano 5 megapixel (di verde), 2,5 megapixel (di blu) e 2,5 megapixel (di rosso).

Volendo schematizzare il funzionamento di un filtro Bayer, potete far riferimento alla figura di seguito: ogni fotodiodo cattura esclusivamente i fotoni della lunghezza d’onda corripondente al filtro, facendo rimbalzare tutti gli altri:

Demosaicizzazione Bayer

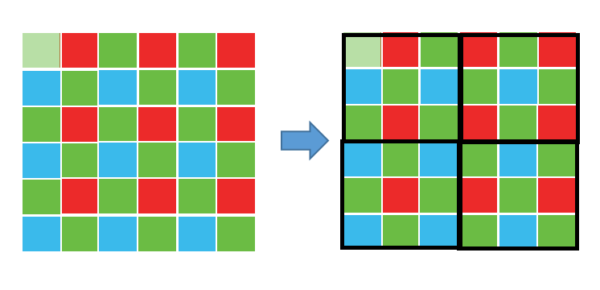

La “demosaicizzazione” Bayer è il processo di traduzione di questa matrice di colori primari Bayer in un’immagine finale che contiene informazioni a colori complete per ogni pixel. Come è possibile se la fotocamera non è in grado di misurare direttamente il colore pieno? Un modo per capire questo è invece di pensare ad ogni matrice 2×2 di rosso, verde e blu come ad un’unica cavità di colore pieno.

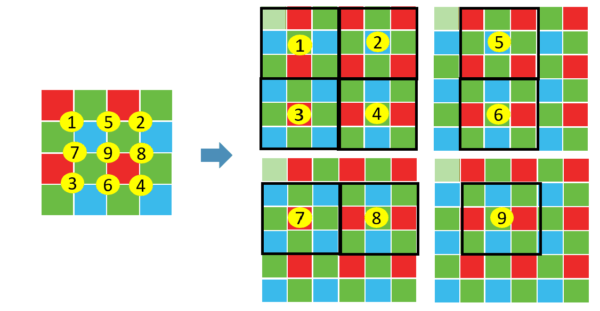

Questo funzionerebbe bene, tuttavia la maggior parte delle telecamere adotta misure aggiuntive per estrarre ancora più informazioni di immagine da questo array di colori. Se la telecamera trattasse tutti i colori di ogni matrice 2×2 come se fossero atterrati nello stesso punto, allora sarebbe in grado di raggiungere solo la metà della risoluzione sia in direzione orizzontale che verticale. D’altra parte, se una telecamera calcolasse il colore usando diversi array 2×2 sovrapposti, allora potrebbe raggiungere una risoluzione più alta di quella che sarebbe possibile con un singolo set di array 2×2. La seguente combinazione di array 2×2 sovrapposti potrebbe essere usata per estrarre più informazioni sull’immagine.

Si noti come non abbiamo calcolato le informazioni dell’immagine ai bordi della matrice, poiché abbiamo ipotizzato che l’immagine continuasse in ogni direzione. Se questi fossero in realtà i bordi della matrice di cavità, allora i calcoli qui sarebbero meno accurati, poiché non ci sono più pixel su tutti i lati. Questo è però tipicamente trascurabile, poiché le informazioni ai bordi stessi di un’immagine possono essere facilmente ritagliate per le telecamere con milioni di pixel.

Esistono altri algoritmi di demosaicizzazione che possono estrarre una risoluzione leggermente maggiore, produrre immagini meno rumorose o adattarsi al meglio all’approssimazione dell’immagine in ogni punto.

Artefatti dovuti alla demosaicizzazione

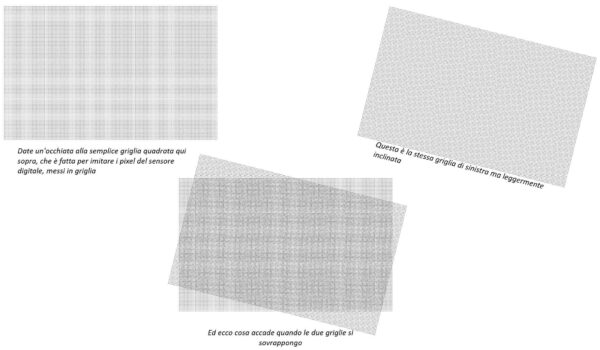

Immagini con dettagli su piccola scala vicino al limite di risoluzione del sensore digitale possono talvolta ingannare l’algoritmo di demosaicizzazione producendo un risultato dall’aspetto irrealistico. L’artefatto più comune è il moiré (pronunciato “more-ay”), che può apparire come pattern ripetuti, artefatti di colore o pixel disposti in un labirinto non realistico:

Si noti la comparsa di moiré in pratica quasi tutta l’immagine. Questi artefatti dipendono sia dal tipo di texture che dal software utilizzato per sviluppare il file RAW della fotocamera digitale.

Tuttavia, anche con un sensore teoricamente perfetto in grado di catturare e distinguere tutti i colori in ogni fotosito, moiré e altri artefatti potrebbero comunque apparire. Questa è una conseguenza inevitabile di qualsiasi sistema che campiona un segnale altrimenti continuo a intervalli o posizioni discrete. Per questo motivo, praticamente ogni sensore digitale fotografico incorpora qualcosa chiamato filtro ottico passa-basso (OLPF) o filtro anti-aliasing (AA). Questo è tipicamente un sottile strato direttamente di fronte al sensore, e funziona sfocando efficacemente ogni dettaglio potenzialmente problematico che è più fine della risoluzione del sensore.

Matrice Bayer: Array di microlenti

I sensori delle fotocamere del mondo reale non hanno in realtà dei siti fotografici che coprono l’intera superficie del sensore. Infatti, essi possono coprire solo la metà dell’area totale per ospitare altri dispositivi elettronici. Ogni cavità viene mostrata con piccoli picchi tra di loro per dirigere i fotoni verso una cavità o l’altra. Le fotocamere digitali contengono “microlenti” sopra ogni fotosito per migliorare la loro capacità di raccolta della luce. Questi obiettivi sono analoghi agli imbuti che dirigono i fotoni nel fotosito dove altrimenti i fotoni sarebbero stati inutilizzati.

Diagramma a matrice di microlenti

Microlenti ben progettate possono migliorare il segnale fotonico in ogni fotosito e, di conseguenza, creare immagini con meno rumore per lo stesso tempo di esposizione. I produttori di fotocamere sono stati in grado di utilizzare i miglioramenti nella progettazione delle microlenti per ridurre o mantenere il rumore nelle più recenti fotocamere ad alta risoluzione, nonostante i fotositi siano più piccoli, grazie alla compressione di più megapixel nella stessa area del sensore.